O uso da inteligência artificial no campo militar tem crescido e seu emprego se dá em guerras atuais e representa um divisor de águas no modo como os conflitos armados são conduzidos. A promessa de maior eficiência e precisão nas operações bélicas é sedutora, mas traz consigo um dilema perturbador: como confiar em máquinas para decidir sobre questões de vida e morte? A automação dessas decisões, que antes pertenciam exclusivamente à esfera humana, inaugura uma era de incertezas éticas e riscos ainda não plenamente compreendidos.

Ao longo da história, cada inovação militar – desde a pólvora até a bomba atômica – redefiniu a maneira como as guerras são travadas, ampliando tanto as capacidades destrutivas quanto os dilemas morais enfrentados por sociedades e líderes. No entanto, a IA traz algo sem precedentes: a possibilidade de despersonalizar o uso da força. Robôs autônomos e algoritmos, desprovidos de moralidade ou empatia, podem ser programados para agir em um campo de batalha sem a supervisão direta de humanos. Essa ruptura levanta questões profundas sobre responsabilidade, dignidade humana e o próprio conceito de justiça em conflitos armados.

Sumário

Uma preocupação maior se dá com a crescente corrida tecnológica entre potências como China e Estados Unidos. Enquanto a China busca “inteligentizar” seus esforços militares, os EUA investem em iniciativas como o Project Maven, que usa IA para analisar imagens e identificar alvos. O avanço rápido do seu uso se dá em grande medida não pela necessidade prática, mas pela busca por supremacia tecnológica, acelerando o emprego da IA sem o devido escrutínio pela sociedade e trabalho diplomático.

Além disso, entidades como a Cruz Vermelha alerta que, embora a IA possa trazer maior precisão, ela também introduz riscos inaceitáveis, como a perda de controle humano e a dificuldade em responsabilizar erros catastróficos, colocando civis e combatentes vulneráveis em perigo.

Dado o contexto, vamos explorar nesta análise os riscos crescentes da aplicação militar da IA, analisando suas implicações éticas, legais e humanitárias. Mais do que um exercício teórico, a busca provocar uma reflexão crítica: até onde estamos dispostos a permitir que o avanço tecnológico subverta os valores humanos e éticos que deveriam guiar a guerra e a paz?

Corrida pela Supremacia Militar com IA

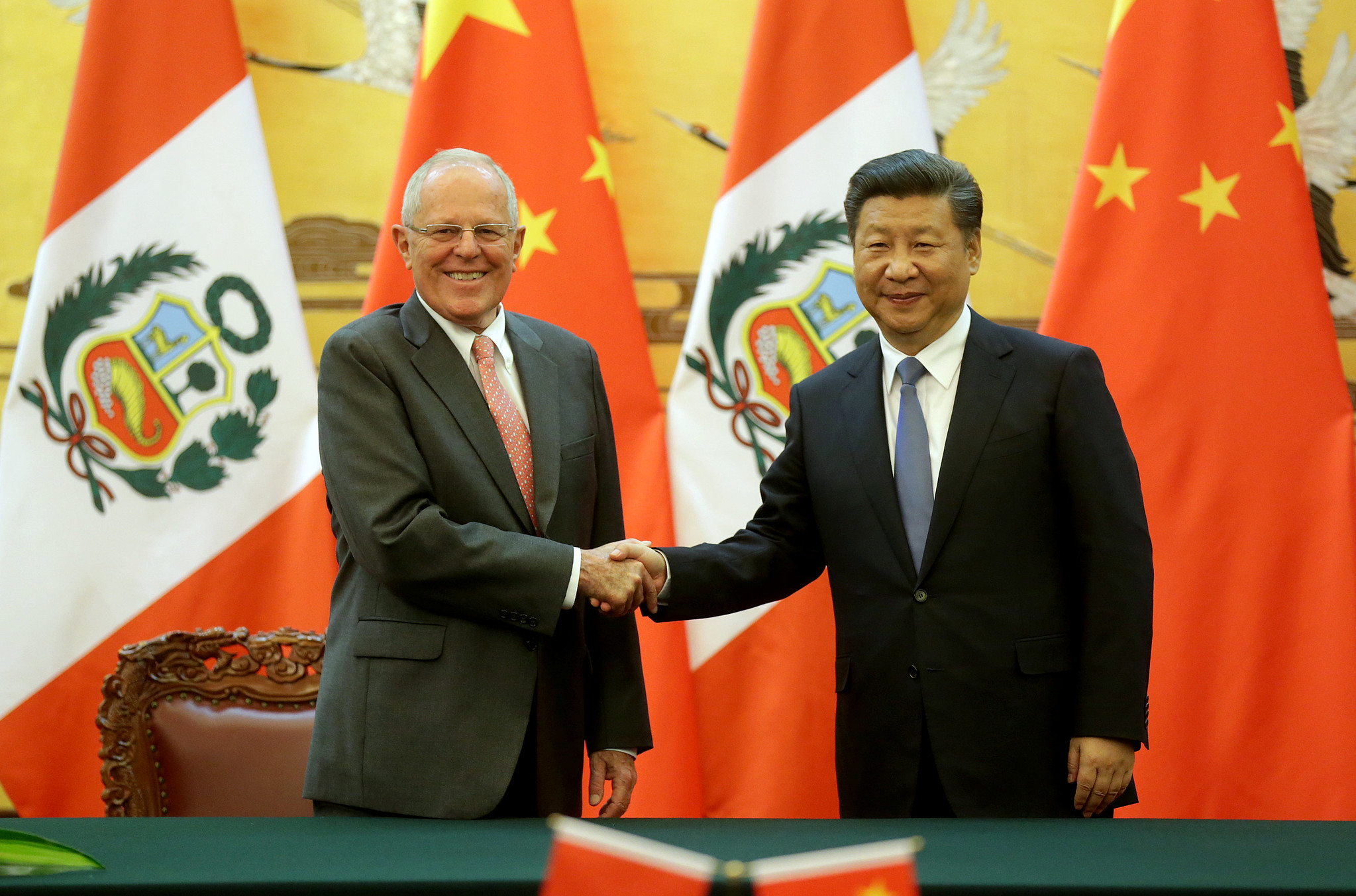

A aplicação de inteligência artificial tornou-se uma prioridade estratégica na corrida tecnológica entre as grandes potências, com destaque para China e Estados Unidos. Ambas as nações têm investido significativamente no desenvolvimento de capacidades militares baseadas em IA, cada uma com estratégias específicas.

China posiciona a “inteligentização” da guerra como um pilar central de sua modernização militar. O Exército de Libertação Popular (PLA) utiliza IA em sistemas de comando e controle, armas autônomas e operações cibernéticas, integrando tecnologias como big data e computação em nuvem. Programas como o Plano de Desenvolvimento de IA de Nova Geração e o papel da Comissão Militar Central demonstram o comprometimento do país em alinhar avanços tecnológicos com capacidades militares. Em discursos, como o de Xi Jinping na 19ª Conferência do Partido Comunista, foi enfatizada a fusão entre desenvolvimento militar e civil, que sustenta o avanço em áreas como ciberespaço e guerra eletrônica.

Enquanto isso, os Estados Unidos buscam alavancar tecnologias de IA em iniciativas como o Project Maven, focado na análise de imagens capturadas por drones para aumentar a precisão em operações. Contudo, a iniciativa enfrentou resistência ética, evidenciada pela oposição de funcionários do Google, que se recusaram a colaborar com projetos militares. Paralelamente, os EUA investem em veículos aéreos não tripulados (UAVs) e robôs terrestres capazes de executar tarefas autônomas, incluindo decisões letais, o que intensifica debates sobre accountability e supervisão humana.

Outras Potências

Além de EUA e China, a Rússia tem direcionado esforços para a robótica militar e a IA aplicada a sistemas de defesa e mísseis. Projetos como o drone de combate Uran-9 e o robô Marker refletem a ambição russa de integrar IA em operações autônomas, mas restrições econômicas e sanções internacionais limitam seu progresso.

Na Europa, potências como França, Alemanha e Reino Unido adotam abordagens colaborativas, priorizando princípios éticos e conformidade com o Direito Internacional. Iniciativas como o Fundo Europeu de Defesa promovem o desenvolvimento de sistemas autônomos regulados, enquanto programas como o Scorpion, liderado pela França, integram IA em veículos de combate e comando.

Desafios da IA no Campo Militar

A aplicação de inteligência artificial no contexto militar promete transformar radicalmente as operações bélicas, oferecendo maior eficiência e precisão. No entanto, essa mesma tecnologia introduz uma série de riscos operacionais e éticos que têm implicações profundas para a paz e segurança internacionais. Enquanto a velocidade de processamento e a automação oferecem vantagens estratégicas, elas também aumentam a probabilidade de falhas e escaladas não intencionais, especialmente em cenários complexos e imprevisíveis como os conflitos armados.

Um dos desafios mais notáveis é o risco de acidentes causados pela confiança excessiva em sistemas de IA. Um exemplo trágico ocorreu em Cabul, em 2021, quando um drone americano, confiando em análises automatizadas, atacou erroneamente uma área residencial, resultando na morte de 10 civis, incluindo crianças. Este incidente ilustra a fragilidade de sistemas que, embora altamente avançados, ainda dependem de dados precisos e de supervisão humana rigorosa para evitar erros críticos. A opacidade dos algoritmos, conhecida como o problema da “caixa-preta”, dificulta a identificação de falhas, aumentando o potencial de erros catastróficos.

A automação em armas letais também levanta preocupações éticas e jurídicas significativas. A introdução de sistemas autônomos cria um “gap de responsabilidade” onde decisões equivocadas podem não ser atribuídas claramente a operadores humanos, desenvolvedores ou aos próprios sistemas de IA. Essa ambiguidade ameaça os princípios do Direito Humanitário Internacional (DHI), que exige que todas as ações em conflitos sejam baseadas em julgamento humano informado e contextual. Por exemplo, operações automatizadas podem falhar ao distinguir combatentes de civis, um princípio fundamental do DHI.

A dinâmica competitiva entre nações exacerba esses riscos. A corrida para desenvolver sistemas de IA militar frequentemente resulta na priorização de velocidade sobre segurança, levando ao uso prematuro de tecnologias ainda não completamente testadas. Esse fenômeno, conhecido como “race to the bottom”, reflete uma preocupação de que sistemas mal avaliados sejam implantados em campo, aumentando a probabilidade de falhas em larga escala. Além disso, a busca por vantagem operacional pode levar a uma escalada de conflitos baseada em interpretações errôneas ou mal-entendidos, especialmente em ambientes onde adversários manipulam dados para enganar sistemas de IA.

Finalmente, as limitações inerentes à IA contemporânea, como sua rigidez em contextos novos e complexos, tornam a integração de humanos indispensável. Embora máquinas sejam capazes de realizar cálculos rápidos e precisos, a flexibilidade cognitiva humana continua sendo essencial em cenários imprevisíveis e caóticos. A combinação ideal, muitas vezes chamada de abordagem “centauro”, integra o poder da IA com o julgamento humano para otimizar operações enquanto reduz os riscos de decisões automatizadas inadequadas. Essa integração, no entanto, depende de treinamento robusto e regulamentação rigorosa para assegurar que as capacidades humanas e mecânicas sejam empregadas de forma complementar e ética.

Integração da IA no Conhecimento Profissional do Exército dos EUA

O relatório “Trusting AI: Integrating Artificial Intelligence into the Army’s Professional Expert Knowledge”, do US Army War College, destaca as complexidades envolvidas na incorporação da IA nas operações militares americanas. Este documento sublinha a dependência crescente da IA para tarefas como reconhecimento de padrões, coleta e análise de dados, além de suporte à tomada de decisão. No entanto, ele alerta que a confiança nesses sistemas deve ser construída sobre transparência, explicabilidade e supervisão humana significativa para mitigar riscos éticos e operacionais.

A criação do Joint Artificial Intelligence Center (JAIC), em 2018, é um marco da estratégia militar americana para IA. Este centro visa acelerar a implementação de capacidades habilitadas por IA em todas as forças armadas, desde veículos autônomos e mísseis de longo alcance até sistemas de logística e manutenção preditiva. Entre os projetos emblemáticos está o Project Maven, que utiliza IA para interpretar imagens aéreas, prometendo maior precisão em operações de reconhecimento e ataque. Apesar disso, enfrentou críticas éticas, incluindo a renúncia de funcionários do Google preocupados com o uso militar da tecnologia.

A abordagem dos EUA também prioriza a criação de uma “literacia em IA” entre seus militares. Programas como o Projeto Ridgway pretendem integrar tecnologias comerciais enquanto preparam as forças armadas para sistemas de próxima geração. No entanto, a implementação plena enfrenta barreiras como restrições orçamentárias e diferenças culturais entre o setor de tecnologia e o complexo militar. Embora o orçamento militar dos EUA seja considerável (778,2 bilhões de dólares em 2020), os investimentos específicos em IA ainda são menores do que os esperados para sustentar a liderança tecnológica no longo prazo.

Riscos e Desafios Éticos no Uso Militar da Inteligência Artificial

A aplicação militar de inteligência artificial introduz riscos significativos, tanto operacionais quanto éticos, que desafiam os limites da supervisão humana e os princípios fundamentais do Direito Humanitário Internacional (DHI). Um dos aspectos mais preocupantes é a opacidade inerente a muitos sistemas de IA, frequentemente descrita como o problema da “caixa-preta”. Essa falta de explicabilidade dificulta a identificação de falhas e compromete a capacidade de responsabilização em casos de erros catastróficos. Em sistemas letais, como drones autônomos e mísseis de precisão, a ausência de controle humano direto pode resultar em decisões com consequências devastadoras, como o ataque equivocado ocorrido em Cabul, em 2021, que resultou na morte de 10 civis.

Além disso, a competição internacional para liderar no desenvolvimento de IA militar exacerba os riscos de uma militarização descontrolada. Países como China, Rússia e Estados Unidos estão engajados em uma corrida tecnológica que frequentemente prioriza velocidade e vantagem operacional sobre segurança e ética. A China, por exemplo, utiliza IA para integrar big data em sistemas de comando e controle, enquanto os EUA lideram em pesquisa e desenvolvimento, investindo cerca de 874 milhões de dólares em IA apenas no orçamento de defesa de 2020. Essa dinâmica intensifica as chances de testes prematuros e implantações arriscadas de sistemas não totalmente validados, com impactos potenciais sobre a estabilidade internacional.

Os sistemas de IA também são vulneráveis a manipulações e ataques cibernéticos. Técnicas como data poisoning, em que dados maliciosos são introduzidos para enviesar algoritmos, podem induzir sistemas a cometer erros críticos, confundindo alvos militares com infraestruturas civis ou interpretando falsamente ações de combate. Além disso, a manipulação adversarial pode explorar fraquezas em sistemas autônomos para gerar reações inesperadas, agravando conflitos de maneira não intencional. Esses riscos evidenciam a necessidade de medidas robustas de segurança cibernética e auditorias contínuas para mitigar vulnerabilidades em operações militares sensíveis.

Implicações Morais e o “Gap de Accountability”

A automação no uso da força ameaça despersonalizar as decisões de vida e morte, transformando a guerra em um processo técnico desprovido de empatia e julgamento moral. Algoritmos programados para otimizar eficácia muitas vezes não conseguem considerar as nuances éticas exigidas em conflitos armados, como a distinção entre combatentes e civis ou a proporcionalidade de um ataque. A centralidade do controle humano nessas decisões é essencial para preservar a dignidade humana e os princípios morais, mas a introdução de armas autônomas dilui essa responsabilidade.

O “gap de accountability” – a lacuna de responsabilidade – é um dos maiores desafios éticos da automação militar. Quando sistemas autônomos cometem erros, torna-se difícil determinar quem deve ser responsabilizado: o operador humano, o desenvolvedor do algoritmo ou o próprio sistema. Esse dilema desafia os fundamentos do DHI, que exige clareza sobre a tomada de decisão e a responsabilização por violações. Sem uma estrutura clara para abordar essa lacuna, existe o risco de que a responsabilidade seja diluída, comprometendo a justiça e a transparência em cenários de guerra.

A Resistência Ética e os Movimentos de Regulação

A crescente preocupação com os impactos éticos da IA militar levou à formação de movimentos internacionais contra o uso indiscriminado de armas autônomas. O Campaign to Stop Killer Robots, por exemplo, destaca os perigos de confiar em sistemas sem supervisão humana significativa, enquanto empresas como a ClearPath Robotics já se comprometeram a não desenvolver robôs armados fora do controle humano. Essas iniciativas refletem uma conscientização crescente sobre os riscos de desumanizar a guerra e a necessidade de regulamentação internacional rigorosa.

Organizações internacionais como o Comitê Internacional da Cruz Vermelha defendem diretrizes claras para garantir a supervisão humana em todas as etapas operacionais de sistemas de IA militar. Essas propostas incluem limites geográficos e temporais para o uso de armas autônomas, mecanismos de desativação de emergência e auditorias regulares de algoritmos. Tais medidas são essenciais para evitar abusos e assegurar que as decisões críticas permaneçam alinhadas às normas éticas e legais internacionais.

O Caminho à Frente: Regulamentação e Supervisão no Uso Militar da IA

A rápida evolução da inteligência artificial no setor militar exige ações concretas para equilibrar inovação tecnológica com responsabilidade ética. A criação de regulamentações internacionais claras é essencial para garantir transparência, supervisão humana significativa e limites para o uso de sistemas autônomos em conflitos armados. Medidas como auditorias independentes, reforço na segurança cibernética e o treinamento contínuo de operadores são indispensáveis para mitigar os riscos associados à automação.

Sem uma regulamentação robusta e coordenada em âmbito internacional, os avanços da IA militar podem comprometer os valores fundamentais que sustentam o Direito Internacional e a estabilidade mundial. O uso da IA em conflitos deve ser guiado por princípios éticos claros, assegurando que a tecnologia promova a eficiência operacional sem violar os direitos humanos ou desestabilizar o cenário internacional. O principal desafio está em alinhar inovação e valores humanitários, evitando que a tecnologia subverta os alicerces que regem os conflitos e a paz.

O Futuro das Guerras com IA

O futuro dos conflitos armados será profundamente moldado pela integração da inteligência artificial, transformando a forma como as guerras são conduzidas e ampliando tanto suas possibilidades quanto seus riscos. Para evitar abusos e proteger vidas humanas, é imprescindível estabelecer marcos regulatórios claros que garantam a supervisão humana significativa em todas as etapas operacionais. O Comitê Internacional da Cruz Vermelha (ICRC) alerta que sistemas autônomos devem ser usados apenas em contextos específicos, com limites geográficos e temporais bem definidos, e acompanhados de mecanismos que permitam a desativação imediata em caso de erro ou escalada imprevista. A supervisão contínua por operadores humanos deve ser prioridade para assegurar que decisões críticas sejam revisadas e executadas de forma ética e responsável.

A ausência de regulamentação robusta aumenta consideravelmente o risco de uma escalada tecnológica descontrolada. Sistemas de IA são particularmente suscetíveis a manipulações adversariais, como alterações em dados que possam induzir erros graves, por exemplo, confundindo alvos militares com civis. Esses equívocos não apenas comprometem a confiabilidade operacional, mas também intensificam a probabilidade de retaliações e escaladas não intencionais, agravando conflitos e colocando em risco a estabilidade internacional.

Portanto, a mitigação dos desafios da IA em contextos militares exige um equilíbrio delicado entre a busca por inovação tecnológica e a responsabilidade ética. Auditorias rigorosas, medidas de segurança cibernética robustas e uma abordagem multilateral coordenada são fundamentais para garantir que o uso da IA respeite os valores humanos e as normas internacionais. Apenas com esforços globais integrados será possível aproveitar os benefícios tecnológicos da IA enquanto se preserva a legitimidade, a moralidade e o compromisso com os princípios que sustentam o Direito Humanitário Internacional.

Referências

KANIA, Elsa B. The military application of artificial intelligence technology in the United States, China, and Russia and the implications for global security. Wilson Center, 2021. Disponível em: https://www.wilsoncenter.org/publication/military-ai-applications. Acesso em: 01 dez. 2024.

US ARMY WAR COLLEGE. Trusting AI: Integrating Artificial Intelligence into the Army’s Professional Expert Knowledge. United States Army War College Press, 2021. Disponível em: https://press.armywarcollege.edu/trusting_ai. Acesso em: 01 dez. 2024.

ICRC (Comitê Internacional da Cruz Vermelha). Autonomous Weapon Systems: Implications of Increasing Autonomy in the Critical Functions of Weapons. Geneva: International Committee of the Red Cross, 2021. Disponível em: https://www.icrc.org/en/document/autonomous-weapons-systems. Acesso em: 01 dez. 2024.

LAURE DE ROUCY-ROCHEGONDE. Guerra na era da inteligência artificial: quando as máquinas pegam em armas. The Conversation, 2024. Disponível em: https://theconversation.com/war-in-the-ai-era. Acesso em: 01 dez. 2024.

Analista de Relações Internacionais, organizador do Congresso de Relações Internacionais e editor da Revista Relações Exteriores. Professor, Palestrante e Empreendedor. Contato profissional: guilherme.bueno(a)esri.net.br